GPU là bộ não của máy tính AI

Nói một cách đơn giản, bộ xử lý đồ họa (GPU) đóng vai trò như bộ não của máy tính AI.

Có thể bạn đã biết, bộ xử lý trung tâm (CPU) là bộ não của máy tính. Lợi ích của GPU nằm ở chỗ nó chính là một CPU chuyên biệt trong việc thực hiện các phép toán phức tạp. Cách nhanh nhất để thực hiện phép toán này là để các nhóm GPU cùng giải một bài toán. Mặc dù vậy, việc huấn luyện mô hình AI vẫn có thể mất nhiều tuần hoặc thậm chí nhiều tháng. Sau khi hoàn tất xây dựng, nó sẽ được đặt trong hệ thống máy tính front-end và người dùng có thể đặt câu hỏi cho mô hình AI, quá trình này được gọi là suy luận.

Một máy tính AI chứa nhiều GPU

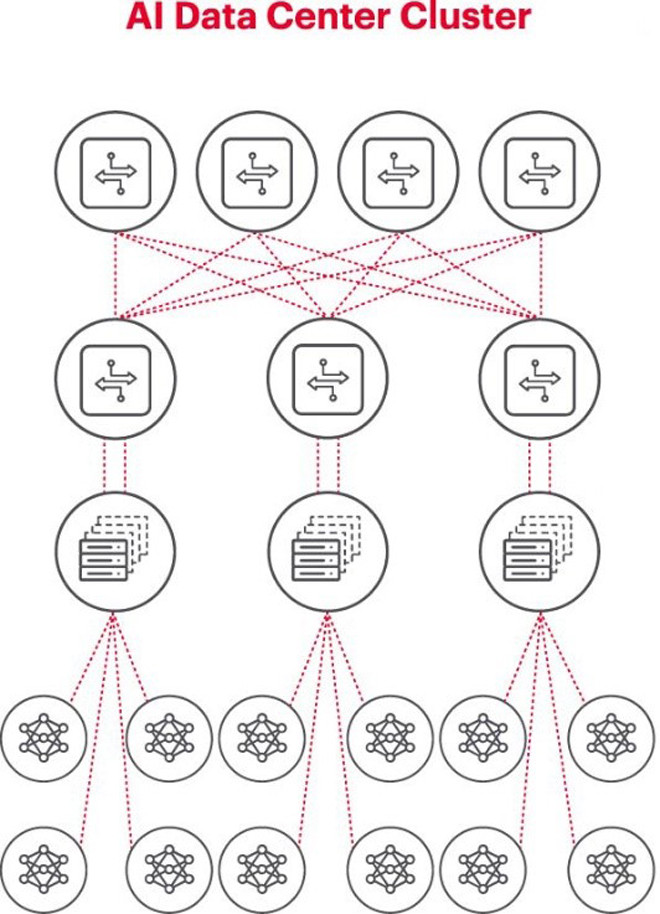

Kiến trúc tốt nhất để giải quyết các bài toán AI là sử dụng một nhóm GPU trong một giá máy, được kết nối với thiết bị chuyển mạch trên nóc giá máy này. Nhiều giá máy GPU có thể được kết nối bổ sung theo hệ thống phân cấp kết nối mạng. Khi các vấn đề cần giải quyết có độ phức tạp cao, yêu cầu về GPU cũng tăng lên, một số dự án có thể phải triển khai các cụm gồm hàng nghìn GPU.

Mỗi cụm AI là một mạng lưới nhỏ

Khi xây dựng cụm AI, cần thiết lập một mạng máy tính nhỏ để kết nối và cho phép các GPU cùng hoạt động, chia sẻ dữ liệu một cách hiệu quả.

Hình trên minh họa một Cụm AI trong đó các vòng tròn ở dưới biểu thị các quy trình công việc chạy trên GPU. GPU kết nối với các thiết bị chuyển mạch trên nóc giá máy (ToR). Các thiết bị chuyển mạch ToR cũng kết nối với các thiết bị chuyển mạch đường trục mạng biểu diễn phía trên sơ đồ, thể hiện một hệ thống phân cấp mạng rõ ràng cần thiết khi có nhiều GPU tham gia.

Mạng là điểm nghẽn trong quá trình triển khai AI

Mùa thu năm ngoái, tại Hội nghị thượng đỉnh toàn cầu của Dự án điện toán mở Open Computer Project (OCP), nơi các đại biểu cùng xây dựng thế hệ cơ sở hạ tầng AI tiếp theo, đại biểu Loi Nguyen từ Marvell Technology đã chỉ rõ một vấn đề quan trọng: "mạng là nút thắt cổ chai mới".

Về mặt kỹ thuật, độ trễ gói tin lớn hoặc mất gói tin do mạng bị tắc nghẽn có thể khiến các gói tin phải được gửi lại, làm tăng đáng kể thời gian hoàn thành công việc (JCT). Kết quả là một số lượng GPU trị giá hàng triệu hoặc hàng chục triệu USD của các doanh nghiệp bị lãng phí do hệ thống AI hoạt động không hiệu quả, gây thiệt hại cho doanh nghiệp cả về doanh thu và thời gian đưa sản phẩm ra thị trường.

Đo kiểm là điều kiện trọng yếu để vận hành thành công mạng AI

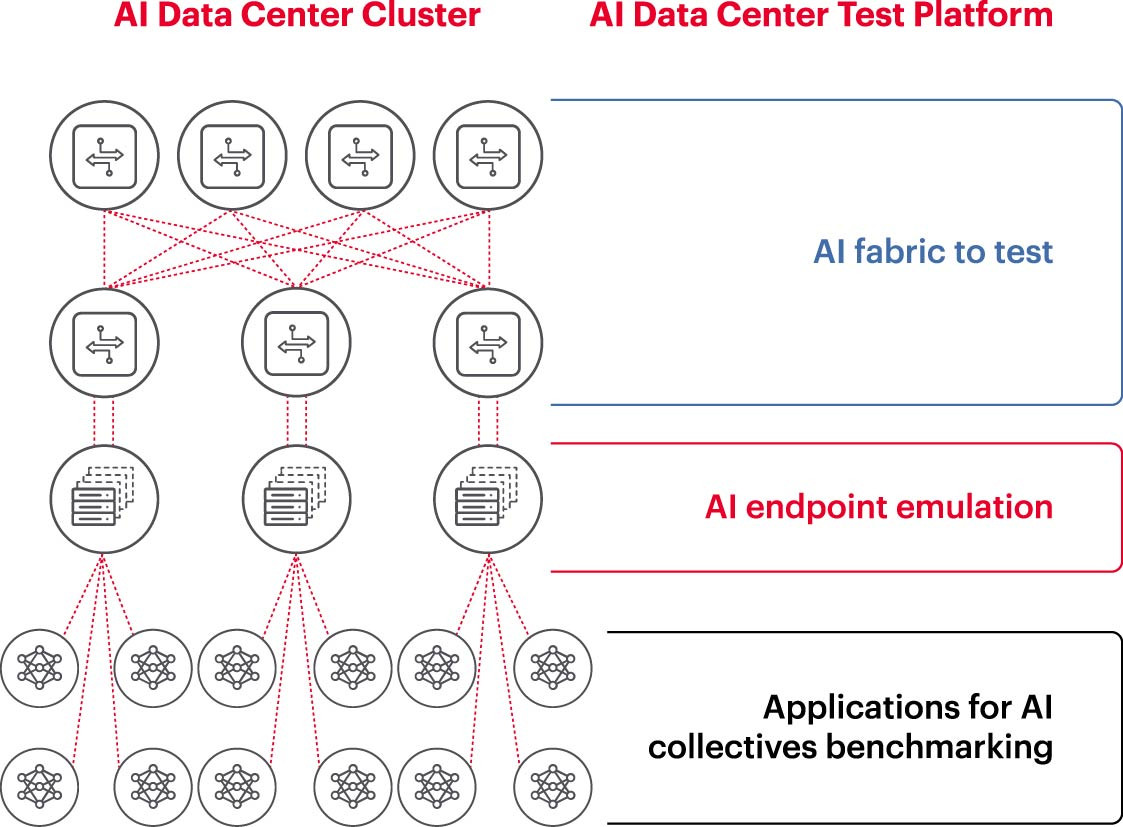

Để vận hành hiệu quả một cụm AI, GPU cần có khả năng sử dụng hết công suất để có thể rút ngắn thời gian huấn luyện và đưa vào sử dụng mô hình học để tăng tối đa tỷ lệ hoàn vốn đầu tư. Vì vậy, cần phải thử nghiệm và đánh giá hiệu năng của cụm AI (Hình 2). Tuy nhiên, nhiệm vụ này không dễ dàng, vì về mặt kiến trúc hệ thống có nhiều thiết lập và mối quan hệ giữa GPU và cấu trúc mạng cần bổ trợ cho nhau để xử lý bài toán.

Điều này tạo ra nhiều khó khăn thách thức trong việc đo kiểm mạng AI:

- Khó khăn trong việc tái tạo toàn bộ mạng sản xuất trong phòng thí nghiệm do hạn chế về chi phí, thiết bị, thiếu hụt về kỹ sư AI mạng có tay nghề cao, không gian, nguồn điện và nhiệt độ.

- Đo kiểm trên hệ thống sản xuất làm giảm năng lực xử lý khả dụng của chính hệ thống sản xuất.

- Khó khăn trong việc tái tạo chính xác các vấn đề do sự khác nhau về quy mô và phạm vi của các bài toán.

- Sự phức tạp trong cách thức kết nối tập thể của các GPU.

Để giải quyết những thách thức này, doanh nghiệp có thể tiến hành đo kiểm một tập hợp con của các thiết lập được đề xuất trong môi trường phòng thí nghiệm để đối chuẩn các tham số chính như JCT (thời gian hoàn thành công việc), băng thông mà nhóm AI có thể đạt được và so sánh với mức độ sử dụng nền tảng chuyển mạch và mức sử dụng bộ nhớ đệm. Phép đo đối chuẩn này giúp tìm ra mức độ cân bằng phù hợp giữa GPU/khối lượng xử lý và thiết kế/cài đặt mạng. Khi hài lòng với kết quả, đội ngũ kiến trúc sư máy tính và kỹ sư mạng có thể áp dụng các thiết lập này vào sản xuất và đo kết quả mới.

Các phòng thí nghiệm nghiên cứu của doanh nghiệp, các viện nghiên cứu và trường đại học đang nỗ lực phân tích mọi khía cạnh của việc xây dựng và vận hành các mạng AI hiệu quả để giải quyết những thách thức khi làm việc trên các mạng lớn, đặc biệt là khi các phương thức thực hành tốt nhất liên tục thay đổi. Phương pháp hợp tác có thể lặp lại này là cách duy nhất để các doanh nghiệp thực hiện các phép đo kiểm khả lặp và thử nghiệm nhanh các kịch bản "nếu - thì" - là nền tảng trong việc tối ưu hóa các mạng lưới phục vụ AI.

(Nguồn: Keysight Technologies)